龙显忠 程成 李云

摘 要:已有的深度监督哈希方法不能有效地利用提取到的卷积特征,同时,也忽视了数据对之间相似性信息分布对于哈希网络的作用,最终导致学到的哈希编码之间的区分性不足. 为了解决该问题,提出了一种新颖的深度监督哈希方法,称之为深度优先局部聚合哈希(Deep Priority Local Aggregated Hashing,DPLAH). DPLAH将局部聚合描述子向量嵌入到哈希网络中,提高网络对同类数据的表达能力,并且通过在数据对之间施加不同权重,从而减少相似性信息分布倾斜对哈希网络的影响. 利用Pytorch深度框架进行DPLAH实验,使用NetVLAD层对Resnet18网络模型输出的卷积特征进行聚合,将聚合得到的特征进行哈希编码学习. 在CIFAR-10和NUS-WIDE数据集上的图像检索实验表明,与使用手工特征和卷积神经网络特征的非深度哈希学习算法的最好结果相比,DPLAH的平均准确率均值要高出11%,同时,DPLAH的平均准确率均值比非对称深度监督哈希方法高出2%.

关键词:深度哈希学习;卷积神经网络;图像检索;局部聚合描述子向量

中图分类号:TP391.4 文献标志码:A

Deep Priority Local Aggregated Hashing

LONG Xianzhong1,2?,CHENG Cheng1,2 ,LI Yun1,2

(1. School of Computer Science & Technology,Nanjing University of Posts and Telecommunications,Nanjing 210023,China;

2. Key Laboratory of Jiangsu Big Data Security and Intelligent Processing,Nanjing 210023,China)

Abstract:The existing deep supervised hashing methods cannot effectively utilize the extracted convolution features, but also ignore the role of the similarity information distribution between data pairs on the hash network, resulting in insufficient discrimination between the learned hash codes. In order to solve this problem, a novel deep supervised hashing method called deep priority locally aggregated hashing (DPLAH) is proposed in this paper, which embeds the vector of locally aggregated descriptors (VLAD) into the hash network, so as to improve the ability of the hash network to express the similar data, and reduce the impact of similarity distribution skew on the hash network by imposing different weights on the data pairs. DPLAH experiment is carried out by using the Pytorch deep framework. The convolution features of the Resnet18 network model output are aggregated by using the NetVLAD layer, and the hash coding is learned by using the aggregated features. The image retrieval experiments on the CIFAR-10 and NUS-WIDE datasets show that the mean average precision (MAP) of DPLAH is 11 percentage points higher than that of non-deep hash learning algorithms using manual features and convolution neural network features, and the MAP of DPLAH is 2 percentage points higher than that of asymmetric deep supervised hashing method.

Key words:deep Hash learning;convolutional neural network;image retrieval;vector of locally aggregated descriptors(VLAD)

隨着信息检索技术的不断发展和完善,如今人们可以利用互联网轻易获取感兴趣的数据内容,然而,信息技术的发展同时导致了数据规模的迅猛增长. 面对海量的数据以及超大规模的数据集,利用最近邻搜索[1](Nearest Neighbor Search,NN)的检索技术已经无法获得理想的检索效果与可接受的检索时间. 因此,近年来,近似最近邻搜索[2](Approximate Nearest Neighbor Search,ANN)变得越来越流行,它通过搜索可能相似的几个数据而不再局限于返回最相似的数据,在牺牲可接受范围的精度下提高了检索效率. 作为一种广泛使用的ANN搜索技术,哈希方法(Hashing)[3]将数据转换为紧凑的二进制编码(哈希编码)表示,同时保证相似的数据对生成相似的二进制编码. 利用哈希编码来表示原始数据,显著减少了数据的存储和查询开销,从而可以应对大规模数据中的检索问题. 因此,哈希方法吸引了越来越多学者的关注.

当前哈希方法主要分为两类:数据独立的哈希方法和数据依赖的哈希方法,这两类哈希方法的区别在于哈希函数是否需要训练数据来定义. 局部敏感哈希(Locality Sensitive Hashing,LSH)[4]作为数据独立的哈希代表,它利用独立于训练数据的随机投影作为哈希函数. 相反,数据依赖哈希的哈希函数需要通过训练数据学习出来,因此,数据依赖的哈希也被称为哈希学习,数据依赖的哈希通常具有更好的性能. 近年来,哈希方法的研究主要侧重于哈希学习方面.

根据哈希学习过程中是否使用标签,哈希学习方法可以进一步分为:监督哈希学习和无监督哈希学习. 典型的无监督哈希学习包括:谱哈希[5](Spectral Hashing,SH);迭代量化哈希[6](Iterative Quantization,ITQ);离散图哈希[7](Discrete Graph Hashing,DGH);有序嵌入哈希[8] (Ordinal Embedding Hashing,OEH)等. 无监督哈希学习方法仅使用无标签的数据来学习哈希函数,将输入的数据映射为哈希编码的形式. 相反,监督哈希学习方法通过利用监督信息来学习哈希函数,由于利用了带有标签的数据,监督哈希方法往往比无监督哈希方法具有更好的准确性,本文的研究主要针对监督哈希学习方法.

传统的监督哈希方法包括:核监督哈希[9] (Supervised Hashing with Kernels,KSH);潜在因子哈希[10](Latent Factor Hashing,LFH);快速监督哈希[11](Fast Supervised Hashing,FastH);监督离散哈希[12](Supervised Discrete Hashing,SDH)等. 随着深度学习技术的发展[13],利用神经网络提取的特征已经逐渐替代手工特征,推动了深度监督哈希的进步. 具有代表性的深度监督哈希方法包括:卷积神经网络哈希[14](Convolutional Neural Networks Hashing,CNNH);深度语义排序哈希[15] (Deep Semantic Ranking Based Hashing,DSRH);深度成對监督哈希[16] (Deep Pairwise-Supervised Hashing,DPSH);深度监督离散哈希[17] (Deep Supervised Discrete Hashing,DSDH);深度优先哈希[18](Deep Priority Hashing,DPH)等. 通过将特征学习和哈希编码学习(或哈希函数学习)集成到一个端到端网络中,深度监督哈希方法可以显著优于非深度监督哈希方法.

到目前为止,大多数现有的深度哈希方法都采用对称策略来学习查询数据和数据集的哈希编码以及深度哈希函数. 相反,非对称深度监督哈希[19](Asymmetric Deep Supervised Hashing,ADSH)以非对称的方式处理查询数据和整个数据库数据,解决了对称方式中训练开销较大的问题,仅仅通过查询数据就可以对神经网络进行训练来学习哈希函数,整个数据库的哈希编码可以通过优化直接得到. 本文的模型同样利用了ADSH的非对称训练策略.

然而,现有的非对称深度监督哈希方法并没有考虑到数据之间的相似性分布对于哈希网络的影响,可能导致结果是:容易在汉明空间中保持相似关系的数据对,往往会被训练得越来越好;相反,那些难以在汉明空间中保持相似关系的数据对,往往在训练后得到的提升并不显著. 同时大部分现有的深度监督哈希方法在哈希网络中没有充分有效利用提取到的卷积特征.

本文提出了一种新的深度监督哈希方法,称为深度优先局部聚合哈希(Deep Priority Local Aggregated Hashing,DPLAH). DPLAH的贡献主要有三个方面:

1)DPLAH采用非对称的方式处理查询数据和数据库数据,同时DPLAH网络会优先学习查询数据和数据库数据之间困难的数据对,从而减轻相似性分布倾斜对哈希网络的影响.

2)DPLAH设计了全新的深度哈希网络,具体来说,DPLAH将局部聚合表示融入到哈希网络中,提高了哈希网络对同类数据的表达能力. 同时考虑到数据的局部聚合表示对于分类任务的有效性.

3)在两个大型数据集上的实验结果表明,DPLAH在实际应用中性能优越.

1 相关工作

本节分别对哈希学习[3]、NetVLAD[20]和Focal Loss[21]进行介绍. DPLAH分别利用NetVLAD和Focal Loss提高哈希网络对同类数据的表达能力及减轻数据之间相似性分布倾斜对于哈希网络的影响.

1. 1 哈希学习

哈希学习[3]的任务是学习查询数据和数据库数据的哈希编码表示,同时要满足原始数据之间的近邻关系与数据哈希编码之间的近邻关系相一致的条件. 具体来说,利用机器学习方法将所有数据映射成{0,1}r形式的二进制编码(r表示哈希编码长度),在原空间中不相似的数据点将被映射成不相似(即汉明距离较大)的两个二进制编码,而原空间中相似的两个数据点将被映射成相似(即汉明距离较小)的两个二进制编码.

为了便于计算,大部分哈希方法学习{-1,1}r形式的哈希编码,这是因为{-1,1}r形式的哈希编码对之间的内积等于哈希编码的长度减去汉明距离的两倍,同时{-1,1}r形式的哈希编码可以容易转化为{0,1}r形式的二进制编码.

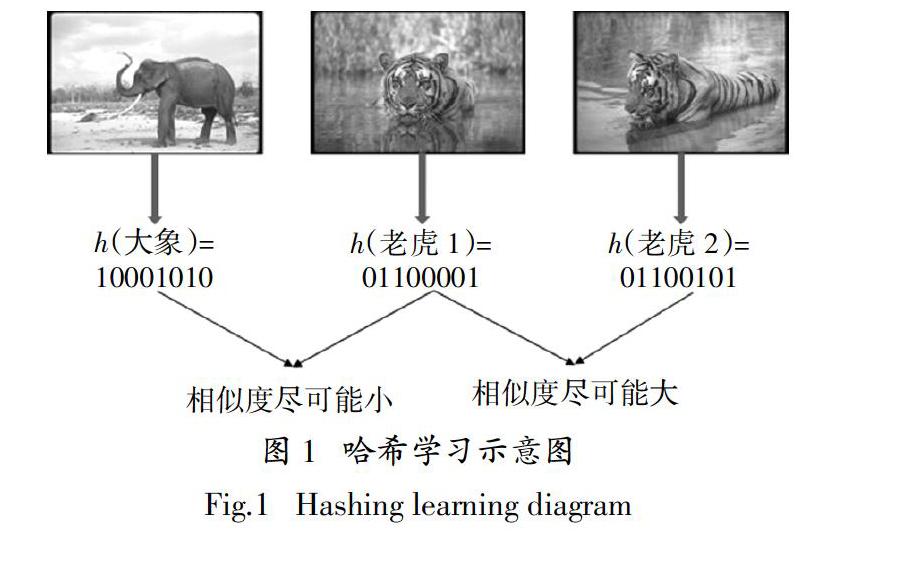

图1是哈希学习的示意图. 经过特征提取后的高维向量被用来表示原始图像,哈希函数h将每张图像映射成8 bits的哈希编码,使原来相似的数据对(图中老虎1和老虎2)之间的哈希编码汉明距离尽可能小,原来不相似的数据对(图中大象和老虎1)之间的哈希编码汉明距离尽可能大.

1. 2 NetVLAD

NetVLAD的提出是用于解决端到端的场景识别问题[20](场景识别被当作一个实例检索任务),它将传统的局部聚合描述子向量(Vector of Locally Aggregated Descriptors,VLAD[22])结构嵌入到CNN网络中,得到了一个新的VLAD层. 可以容易地将NetVLAD使用在任意CNN结构中,利用反向传播算法进行优化,它能够有效地提高对同类别图像的表达能力,并提高分类的性能.

NetVLAD的编码步骤为:利用卷积神经网络提取图像的卷积特征;利用NetVLAD层对卷积特征进行聚合操作. 图2为NetVLAD层的示意图. 在特征提取阶段,NetVLAD会在最后一个卷积层上裁剪卷积特征,并将其视为密集的描述符提取器,最后一个卷积层的输出是H×W×D映射,可以将其视为在H×W空间位置提取的一组D维特征,该方法在实例检索和纹理识别任务[23-24]中都表现出了很好的效果.

NetVLAD在特征聚合阶段,利用一个新的池化层对裁剪的CNN特征进行聚合,这个新的池化层被称为NetVLAD层. NetVLAD的聚合操作公式如下:

V(j,k) = ak(xi)(xi(j) - ck(j)) (1)

式中:xi(j)和ck(j)分别表示第i个特征的第j维和第k个聚类中心的第j维;ak(xi)表示特征xi与第k个视觉单词之间的权. NetVLAD特征聚合的输入为:NetVLAD裁剪得到的N个D维的卷积特征,K个聚类中心.

VLAD的特征分配方式是硬分配,即每个特征只和对应的最近邻聚类中心相关联,这种分配方式会造成较大的量化误差,并且,这种分配方式嵌入到卷积神经网络中无法进行反向传播更新参数. 因此,NetVLAD采用软分配的方式进行特征分配,软分配对应的公式如下:

ak(xi) = (2)

如果α→+∞,那么对于最接近的聚类中心,ak(xi)的值为1,其他为0. ak(xi)可以进一步重写为:

ak(xi) = (3)

式中:wk = 2αck;bk = -α‖ck‖2. 最终的NetVLAD的聚合表示可以写为:

V(j,k)=(xi(j) - ck(j)) (4)

1.3 Focal Loss

对于目标检测方法,一般可以分为两种类型:单阶段目标检测和两阶段目标检测,通常情况下,两阶段的目标检测效果要优于单阶段的目标检测. Lin等人[21]揭示了前景和背景的极度不平衡导致了单阶段目标检测的效果无法令人满意,具体而言,容易被分类的背景虽然对应的损失很低,但由于图像中背景的比重很大,对于损失依旧有很大的贡献,从而导致收敛到不够好的一个结果. Lin等人[21]提出了Focal Loss应对这一问题,图3是对应的示意图. 使用交叉熵作为目标检测中的分类损失,对于易分类的样本,它的损失虽然很低,但数据的不平衡导致大量易分类的损失之和压倒了难分类的样本损失,最终难分类的样本不能在神经网络中得到有效的训练. Focal Loss的本质是一种加权思想,权重可根据分类正确的概率pt得到,利用γ可以对该权重的强度进行调整.

针对非对称深度哈希方法,希望难以在汉明空间中保持相似关系的数据对优先训练,具体来说,对于DPLAH的整体训练损失,通过施加权重的方式,相对提高难以在汉明空间中保持相似关系的数据对之间的训练损失. 然而深度哈希学习并不是一个分类任务,因此无法像Focal Loss一样根据分类正确的概率设计权重,哈希学习的目的是学到保相似性的哈希编码,本文最终利用数据对哈希编码的相似度作为权重的设计依据,具体的权重形式将在模型部分详细介绍.

2 深度优先局部聚合哈希

2. 1 基本定義

DPLAH模型采用非对称的网络设计. Q={qi}n

i=1表示n张查询图像,X = {xi}m

i=1表示数据库有m张图像;查询图像和数据库图像的标签分别用Z = {zi}n

i=1和Y = {yi}m

i=1表示;zi = [zi1,…,zic]T,i = 1,…,n;c表示类别数;如果查询图像qi属于类别j, j = 1,…,c;那么zij = 1,否则zij = 0. 利用标签信息,可以构造图像对的相似性矩阵S∈{-1,1}n × m,sij = 1表示查询图像qi和数据库中的图像xj语义相似,sij = -1表示查询图像qi和数据库中的图像xj语义不相似. 深度哈希方法的目标是学习查询图像和数据库中图像的哈希编码,查询图像的哈希编码用U∈{-1,1}n × r,表示,数据库中图像的哈希编码用B∈{-1,1}m × r表示,其中r表示哈希编码的长度.

对于DPLAH模型,它在特征提取部分采用预训练好的Resnet18网络[25]. 图4为DPLAH网络的结构示意图,利用NetVLAD层聚合Resnet18网络提取到的卷积特征,哈希编码通过VLAD编码得到,由于VLAD编码在分类任务中被广泛使用,于是本文将NetVLAD层的输出作为分类任务的输入,利用图像的标签信息监督NetVLAD层对卷积特征的利用. 事实上,任何一种CNN模型都能实现图像特征提取的功能,所以对于选用哪种网络进行特征学习并不是本文的重点.

2. 2 DPLAH模型的目标函数

为了学习可以保留查询图像与数据库图像之间相似性的哈希编码,一种常见的方法是利用相似性的监督信息S∈{-1,1}n × m、生成的哈希编码长度r,以及查询图像的哈希编码ui和数据库中图像的哈希编码bj三者之间的关系[9],即最小化相似性的监督信息与哈希编码对(ui,bj)内积之间的L2损失. 考虑到相似性分布的倾斜问题,本文通过施加权重来调节查询图像和数据库图像之间的损失,其公式可以表示为:

J = (1-wij)α(uT

ibj - rsij)2

s.t. U∈{-1,1}n × r,B∈{-1,1}m × r,W∈Rn × m

(5)

受Focal Loss启发,希望深度哈希网络优先训练相似性不容易保留图像对,然而Focal Loss利用图像的分类结果对损失进行调整,因此,需要重新进行设计,由于哈希学习的目的是为了保留图像在汉明空间中的相似性关系,本文利用哈希编码的余弦相似度来设计权重,其表达式为:

wij =

,sij = 1

,sij = -1 (6)

式中:ui和bj分别表示查询图像i和数据库图像j的哈希编码;sij = 1表示图像i和j语义相似,sij = -1表示图像i和j语义不相似. 从公式(6)中可以发现,若ui和bj越相似,且图像i和j语义相似,则wij的值接近1,这就表示哈希编码ui和bj相似的难度低;反之ui和bj不相似,而图像i和j语义相似,则wij的值接近0,这就表示哈希编码ui和bj相似的难度高. 本文希望深度哈希网络优先关注相似难度高的图像对,因此对查询图像和数据库图像之间施加权重(1-wij)α,α是一个超参数.

对于查询图像的哈希编码{ui}n

i=1∈U而言,它是离散值,所以不能直接利用反向传播算法(BP)来更新神经网络的参数Θ. 为了使神经网络能够进行反向传播,使用tanh(L)激活函数来近似表示U,其中L = {li}n

i=1表示图像网络中哈希层的输出,对应的优化问题(5)可以被重新表示为:

J = (1-wij)α(tanh(li)Tbj - rsij)2

s.t. B∈{-1,1}m × r (7)

使用Ψ={1,2,…,m}表示数据库中所有图像的索引,随机地从数据库中选择nΨΥ张图像创建查询集,并用Υ = {i1,i2,…,in}?Ψ表示查询集的索引. 此时,公式(7)可以表示为:

J = (1-wij)α(tanh(li)Tbj - rsij)2

s.t. B∈{-1,1}m × r (8)

创建的查询集通过深度哈希网络生成哈希编码,同样它们在整个数据集中的哈希编码也可以通过优化直接得到,因此,还需要保证查询集在哈希网络中学习到的哈希编码要与数据集中的哈希编码尽可能相同. 对应的优化问题可进一步表示为:

J = (1-wij)α(tanh(li)Tbj - rsij)2 +

β(bi - tanh(li))2

s.t. B∈{-1,1}m × r (9)

由于VLAD对于图像具有较好的表示性能,并且VLAD同样被广泛运用于图像分类任务中,因此,NetVLAD层的输出对于分类任务也依然有效,并将NetVLAD层的输出pi作为分类网络的输入. 利用NetVLAD在分类网络中的预测标签和图像的真实标签之间的损失更新网络参数,希望图像哈希网络能够提取到更具有判别力的特征. 最终,DPLAH的目标函数可写为:

J=(1-wij)α(tanh(li)Tbj-rsij)2 +

β(bj-tanh(li))2+μ‖yi-WTpi‖2

2

s.t. B∈{-1,1}m × r (10)

2.3 學习过程

本文采用迭代优化的方式来学习DPLAH网络的参数Θ和数据库图像的哈希编码B. 算法1是整个DPLAH算法的学习过程.

固定B,学习参数Θ. 当B被固定,直接使用反向传播算法(BP)来更新参数Θ,具体来说,从查询集中采样一个批次的图像来更新深度哈希网络的参数.

固定参数Θ,学习B. 当深度哈希网络的参数Θ被固定时,使用与非对称深度哈希[19]相同的优化策略来更新数据库中的哈希编码B,公式如下所示:

B*k = -sign(2[B][^]k[U][^]T

kU*k - 2rSTU-2βU) (11)

式中:B*k表示B的第k列;[B][^]k是矩阵B除了第k列的矩阵;U*k表示U的第k列;[U][^]k是矩阵U除了第k列的矩阵;S为相似性矩阵.

算法1 DPLAH学习算法

输入:m张数据库图像X = {xi}m

i=1,数据库图像标签Y = {yi}m

i=1,相似性

矩阵S∈{-1,1}n × m

输出:DPLAH的网络参数Θ,数据库图像的哈希编码B

1:初始化:Θ和B,哈希编码长度r,最小批次大小g,迭代次数tl和

ts,查询图像个数n

2:for t1 = 1→tl

3:

随机从数据库图像Ψ中采样生成查询集Υ

4:

for t2 = 1→ts

5: for k = 1→n/g

6 随机采取查询图像中的g张作为一个批次

7: 利用BP算法更新Θ:Θ ← Θ - μ·[Δ]Θ(J)

8: end

9: for i = 1→r

10: 按照公式(11)更新B* i

11: end

12: end

13:end

3 实验设计与分析

3. 1 实验设计

3.1.1 数据集

为了验证DPLAH算法的有效性,在CIFAR-10[26]和NUS-WIDE[27]数据集上进行实验.

CIFAR-10数据集由60 000张32×32的RGB彩色图像构成,它是一个用于识别普适物体的数据集. 这些图像被手动标记为10个类别,分别是飞机、汽车、鸟、猫、鹿、狗、青蛙、马、船和卡车.

NUS-WIDE是一个真实的网络数据集,一共包含269 648张图像,每张图像都与来自81个语义类别中的一个或多个类别相关联. 本文遵循与ADSH类似的实验方案,使用最常见的21个类别中的图像,其中每个类别中至少包含了5 000张图像,从而总共使用了195 834张图像.

3.1.2 实验运行环境及超参数配置

所有关于DPLAH的实验都是利用Pytorch深度框架完成的,利用预训练好的Resnet18网络[25]提取图像的特征,NetVLAD层对Resnet18模型输出的卷积特征进行聚合,最后,利用聚合得到的特征进行哈希编码的学习.

对CIFAR-10和NUS-WIDE数据集,NetVLAD的聚类中心个数设置为64. 超参数β、μ和Υ分别设置为200、200和2 000,DPLAH网络的学习率在10-7 ~ 10-3区间进行调整,tl和ts分别为60和3,超参数α为0.2.

在本文实验中,使用到的NetVLAD层去掉了规范化操作,由于整个数据集的哈希编码是通过优化算法直接得到,因此在训练初期并不使用权重. 具体来说,当超参數tl的值小于10时,都不施加优先权重;当tl的值大于10时,施加权重进行训练的同时,会对学习率进行调整.

3.1.3 实验对比

按照现有的深度哈希方法中的评估指标,使用平均准确率均值(MAP)和Top-5K精度来评估DPLAH算法的性能. 对于NUS-WIDE数据集,计算前5 000张返回图像的MAP. 对于CIFAR-10数据集,在每个类别中选取100张图像作为测试图像,对于NUS-WIDE数据集,同样在每个类别中选取100张图像作为测试图像,因此这两个数据集的测试图像数量分别为1 000和2 100张,剩余图像作为数据库图像. 遵循非对称深度哈希等方法[19]在图像相似性上的构造方法,利用图像标签构造用于深度哈希函数学习的相似性矩阵. 具体来说:若两张图像共享至少一个标签,则它们被视为语义相似对,否则,它们是语义不相似的图像对.

多种哈希学习方法被用来与DPLAH进行比较,如SH、ITQ等无监督的哈希方法(包括SH+CNN、ITQ+CNN),SDH、FastH和LFH等有监督的哈希方法(包括SDH+CNN、FastH+CNN和LFH+CNN),CNNH、DPSH和ADSH等深度哈希方法(其中CNNH是两阶段的深度哈希学习方法,其他都是端到端的深度哈希学习方法).

3.2 实验结果和分析

在两个数据集上的MAP对比结果如表1所示. 由于ADSH算法的优越性能,它成为本文重点比较的方法. 为了进行公平的比较,此处利用Pytorch版本的ADSH来进行实验对比,预训练好的Resnet18模型同样会被用来提取图像的卷积特征,其他哈希算法的实验结果来源于DPSH[16]和ADSH[19].

表1中的非深度哈希学习算法使用图像的手工特征,同时也比较了使用CNN特征的非深度哈希学习算法,可以发现端到端的深度哈希方法优于传统的哈希学习方法,非对称的深度哈希方法优于对称的深度哈希方法. 与LFH+CNN的最好结果0.814相比,DPLAH的平均准确率均值要高出11%,同时,DPLAH的平均准确率均值最多比非对称深度监督哈希方法ADSH高出2%.

由于非对称深度监督哈希方法(ADSH)的性能远优于其他哈希学习方法,因此,比较DPLAH 和ADSH在不同比特长度下的Top-5K精度,结果如图5所示.由表1和图5可知,DPLAH无论在MAP还是Top-5K精度的衡量下,其性能都优于现有的深度监督哈希方法.

根据实验结果,发现DPLAH方法在NUS-WIDE数据集上性能较好. 这可能由于NUS-WIDE数据集中的图像来自于真实世界,图像中包含的内容非常丰富;而NetVLAD的提出就是为了解决现实中的场景识别问题,在面对图像中的光线变化、视角变化等情况,具备一定的鲁棒性,从而使得DPLAH方法在NUS-WIDE数据集上的性能较好.

为了验证NetVLAD层确实能学习到具有区分力的哈希编码,本文在NUS-WIDE数据集不使用优先权重的条件下,仅仅将NetVLAD层加入哈希网络中,对比不同比特长度下的MAP. 实验结果如图6所示.

图7为DPLAH算法基于汉明距离排序的搜索结果. 结果是基于32 bits的哈希编码长度给出的几个示例. 在图7中,每行图片中的第1张代表查询图像,后面10张图像表示与查询图像的汉明距离最近的10张图像. 由图7可知,DPLAH算法具有优越的性能,尽管还存在一些错误的搜索结果(示例中最后一行的查询图像是飞机,然而检索出的图像是轮船),但这在接受的范围内.

4 结 论

本文提出了一种基于局部聚合的深度优先哈希方法,在应对相似性分布倾斜方面,受到了Focal Loss的启发,利用查询图像在哈希网络中学习的哈希编码和整个数据库图像的哈希编码之间的余弦相似度,设计了损失函数的优先权重,使得深度哈希网络优先关注相似难度高的图像,从而保证难以在汉明空间中保持相似关系的图像对得到充分训练. 在哈希特征提取方面,由于NetVLAD层能够有效地提高对同类别图像的表达能力,因此利用NetVLAD層将卷积得到的特征进行聚合,从而使学到的哈希编码更具有区分性. 在CIFAR-10和NUS-WIDE两个数据集下进行了实验,将DPLAH与多种哈希学习方法进行比较,通过实验分析,表明了DPLAH算法的优越性能.

参考文献

[1] CLARKSON K L. Fast algorithms for the all nearest neighbors problem[C]//24th Annual Symposium on Foundations of Computer Science (sfcs 1983). Tucson,AZ,USA:IEEE,1983:226—232.

[2] ANDONI A,INDYK P. Near-optimal Hashing algorithms for approximate nearest neighbor in high dimensions[C]//2006 47th Annual IEEE Symposium on Foundations of Computer Science (FOCS′06). Berkeley,CA,USA:IEEE,2006:459—468.

[3] 李武军,周志华. 大数据哈希学习:现状与趋势[J]. 科学通报,2015,60(5/6):485—490.

LI W J,ZHOU Z H. Learning to Hash for big data:current status and future trends[J]. Chinese Science Bulletin,2015,60(5/6):485—490. (In Chinese)

[4] DATAR M,IMMORLICA N,INDYK P,et al. Locality-sensitive Hashing scheme based on p-stable distributions[C]//Proceedings of the Twentieth Annual Symposium on Computational Geometry-SCG 04. Brooklyn,New York:ACM Press,2004:253—262.

[5] WEISS Y,TORRALBA A,FERGUS R. Spectral Hashing[C]// IEEE Advances in Neural Information Processing Systems Conference. Vancouver,BC,Canada:NIPS,2008:1753—1760.

[6] GONG Y C,LAZEBNIK S,GORDO A,et al. Iterative quantization:a procrustean approach to learning binary codes for large-scale image retrieval[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2013,35(12):2916—2929.

[7] LIU W,MU C,KUMAR S,et al. Discrete graph Hashing[J]. Advances in Neural Information Processing Systems,2014,4:3419—3427.

[8] LIU H,JI R,WU Y,et al. Towards optimal binary code learning via ordinal embedding[C]// AAAI Conference on Artificial Intelligence. Phoenix,AZ,USA:AAAI,2016:1258—1265.

[9] LIU W,WANG J,JI R R,et al. Supervised Hashing with kernels[C]//2012 IEEE Conference on Computer Vision and Pattern Recognition. Providence,RI,USA:IEEE,2012:2074—2081.

[10] ZHANG P,ZHANG W,LI W J,et al. Supervised Hashing with latent factor models[C]// Proceedings of the 37th International ACM SIGIR Conference on Research & Development in Information Retrieval. Gold Coast,QLD,Australia:SIGIR,2014:173—182.

[11] LIN G S,SHEN C H,SHI Q F,et al. Fast supervised Hashing with decision trees for high-dimensional data[C]// IEEE Conference on Computer Vision and Pattern Recognition. Columbus,OH,USA:IEEE,2014:1971—1978.

[12] SHEN F M,SHEN C H,LIU W,et al. Supervised discrete Hashing[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston,MA,USA:IEEE,2015:37—45.

[13] LECUN Y,BENGIO Y,HINTON G. Deep learning[J]. Nature,2015,521(7553):436—444.

[14] XIA R,PAN Y,LAI H,et al. Supervised Hashing for image retrieval via image representation learning[C]// AAAI Conference on Artificial Intelligence. Quebec City,QC,Canada:AAAI,2014:2156—2162.

[15] ZHAO F,HUANG Y Z,WANG L,et al. Deep semantic ranking based Hashing for multi-label image retrieval[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston,MA,USA:IEEE,2015:1556—1564.

[16] LI W J,WANG S,KANG W C. Feature learning based deep supervised Hashing with pairwise labels[C]// International Joint Conference on Artificial Intelligence. New York,USA:IJCAI,2016:1711—1717.

[17] LI Q,SUN Z,HE R,et al. Deep supervised discrete Hashing[C]// Advances in Neural Information Processing Systems Conference. Long Beach,CA,USA:NIPS,2017:2482—2491.

[18] CAO Z J,SUN Z P,LONG M S,et al. Deep priority Hashing[C]// ACM International Conference on Multimedia. Seoul,Korea:MM,2018:1653—1661.

[19] JIANG Q Y,LI W J. Asymmetric deep supervised Hashing[C]// AAAI Conference on Artificial Intelligence. New Orleans,LA,USA:AAAI,2018:3342—3349.

[20] ARANDJELOVI[C]R,GRONAT P,TORII A,et al. NetVLAD:CNN architecture for weakly supervised place recognition[C]// IEEE Conference on Computer Vision and Pattern Recognition. Las Vegas,NV,USA:IEEE,2016:5297—5307.

[21] LIN T Y,GOYAL P,GIRSHICK R,et al. Focal loss for dense object detection[C]//2017 IEEE International Conference on Computer Vision (ICCV).Venice,Italy:IEEE,2017:2999—3007.

[22] J?GOU H,PERRONNIN F,DOUZE M,et al. Aggregating local image descriptors into compact codes[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2012,34(9):1704—1716.

[23] YANDEX A B,LEMPITSKY V. Aggregating local deep features for image retrieval[C]//2015 IEEE International Conference on Computer Vision (ICCV). Santiago,Chile:IEEE,2015:1269—1277.

[24] CIMPOI M,MAJI S,VEDALDI A. Deep filter banks for texture recognition and segmentation[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Boston,MA,USA:IEEE,2015:3828—3836.

[25] HE K M,ZHANG X Y,REN S Q,et al. Deep residual learning for image recognition[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas,NV,USA:IEEE,2016:770—778.

[26] KRIZHEVSKY A,HINTON G. Learning multiple layers of features from tiny images[J]. Handbook of Systemic Autoimmune Diseases,2009,1(4):1—60.

[27] CHUA T S,TANG J H,HONG R C,et al. NUS-WIDE:a real-world web image database from National University of Singapore[C]//Proceeding of the ACM International Conference on Image and Video Retrieval-CIVR09. Santorini,Fira,Greece. New York:ACM Press, 2009:368—375.

猜你喜欢 卷积神经网络 三维重定向图像主观和客观质量评价方法计算机应用(2019年5期)2019-08-01基于稀疏卷积神经网络的考生识别算法现代电子技术(2019年13期)2019-07-08基于卷积神经网络的道路交通速度预测电脑知识与技术(2019年9期)2019-05-24浅析卷积神经网络的图像特征提取技术科技视界(2019年7期)2019-05-13基于语谱图的老年人语音情感识别方法软件导刊(2018年9期)2018-12-10基于卷积神经网络的微表情识别中国新技术新产品(2018年16期)2018-10-31基于深度学习的肺结节检测神州·下旬刊(2018年7期)2018-07-28基于残差网络的图像超分辨率算法改进研究软件导刊(2018年4期)2018-05-15基于卷积神经网络车辆品牌和型号识别电子技术与软件工程(2018年6期)2018-02-23基于卷积神经网络的图像检索计算机时代(2018年1期)2018-01-26 相关热词搜索: 局部 深度 聚合